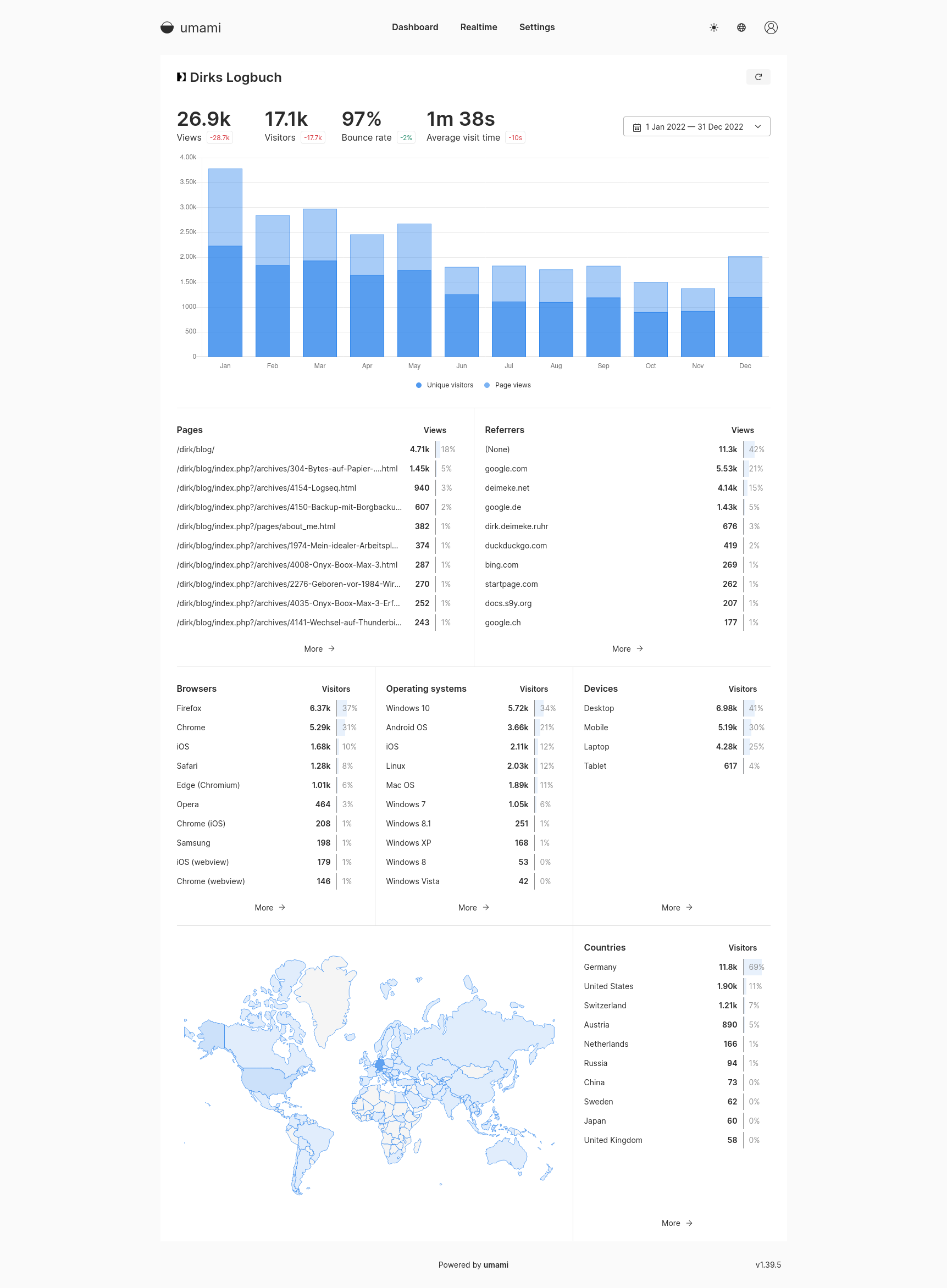

Notizen, noch einmal

Wie bereits in den vorhergehenden Artikeln geschrieben, bin ich auf der Suche nach einer neuen Notizanwendung (weitere Artikel findet Ihr als Trackbacks unter dem verlinkten Posting).

TL;DR: Ich bleibe bei Logseq.

Der Hauptpunkt für mich ist, dass ich klar bekommen muss, ob ich mich so sehr an den Workflow mit Logseq gewöhnt habe, dass ich davon nicht wegkann. Oder, ob ich mich auf ein anderes Ökosystem mit anderen Stärken und auch Schwächen einlassen kann.

In der letzten Runde sind die folgenden zwei Anwendungen geblieben. Die Auswahl folgt komplett subjektiven Kriterien wie beispielsweise der Sympathie oder dem ersten Eindruck.

- Joplin (mal wieder) mit Sync via Nextcloud).

- Notesnook (Zufallsfund und bisher noch nicht in den anderen Artikeln erwähnt).

Im Rahmen des Tests der beiden Applikationen Joplin und Notesnook bin ich nicht alle Features durchgegangen. Mir ging es eher darum herauszufinden, wie sich die Arbeit mit den Tools anfühlt und ob es mir Spass machen könnte, mit Ihnen zu arbeiten.

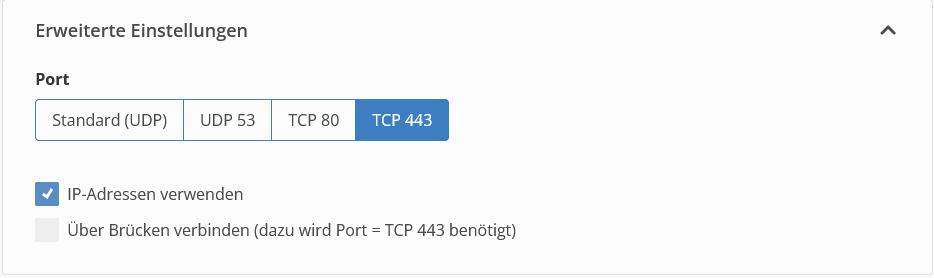

Joplin lässt sich leicht mit der eigenen Nextcloud verbinden, fühlt sich aber ein wenig behäbig an. Mir gefällt gut, dass alle Anwendungen Open-Source-Software sind und dass ich die Daten selber hosten kann. Mit allen Anwendungen meine ich die Desktop-Anwendung, sowie mobil wie auch der Web Clipper. Bei meinen Tests habe ich es nicht geschafft, den Webclipper zur Zusammenarbeit zu bewegen und leider auch nicht hinbekommen, Notizen miteinander zu vernetzen. Wie geschrieben, habe ich nicht sehr intensiv gesucht.

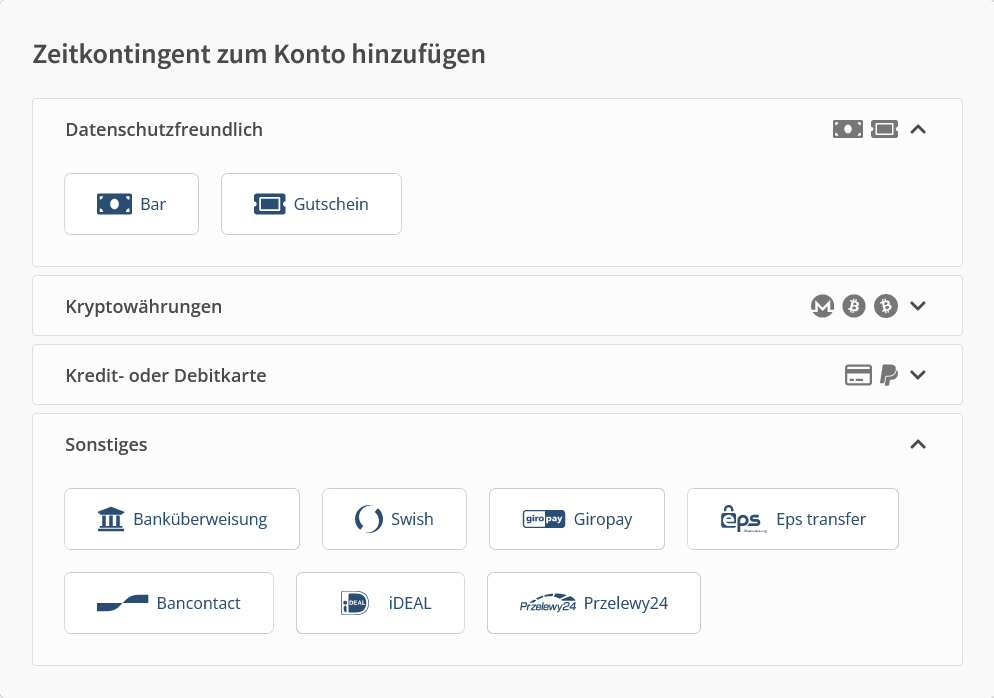

Notesnook war ein absoluter Zufallsfund. Mir war das kleine Entwicklerteam sehr sympathisch, ausserdem ist es eine echte "SAP"-Anwendung ("Software aus Pakistan"). Die Anwendung (Desktop, Mobil, Web Clipper) ist ebenfalls Open-Source-Software, das Sync-Backend wird auf Hetzner-Servern gehostet, an einer Möglichkeit zum Selfhosting wird gearbeitet. Notesnook bietet zusätzlich eine gehostete Webanwendung an. Das Arbeiten mit der Anwendung fühlt sich sehr gut und sehr performant an. Nachdem ich die mobile Anwendung aus F-Droid installiert habe funktionierte der Sync nicht mehr. Das empfohlene Update auf die Beta von Version 3 habe ich durchgeführt, damit kam der Web Clipper aber nicht zurecht. Da braucht es vermutlich noch eine Iteration. Mir ist auch hier nicht klar, wie ich Notizen miteinander verknüpfen kann.

Mir ist Notesnook sympathischer als Joplin – wie gesagt, es ist alles subjektiv. Und ich kann mir vorstellen, in der Zukunft darauf umzustellen. Notesnook bietet einige interessante Security-Features: zwei-Faktor-Authentisierung per Default, verschlüsselte Notizablage. Zum derzeitigen Zeitpunkt ist aber an eine Umstellung nicht zu denken.

Zu meinen Kriterien (finden sich auch im Ursprungsartikel):

- Funktioniert auch offline, soll aber synchronisieren können.

- Check

- Clients für Android, Linux und Windows.

- Check (sogar plus Web Clipper)

- Möglichkeit, Datums basiert Notizen zu machen (Journal, ohne "ing").

- Nicht defaultmässig.

- Verlinkung und Tagging, Aufbau eines "Knowledge Graphs".

- Noch nicht.

- Offenes Dateiformat (gerne Markdown).

- Joplin bietet JEX (json-basiert).

- Notesnook hat ein eigenes Format.

- Nach Möglichkeit Open-Source-Software (ist aber nicht zwingend).

- Check.

- Darf auch etwas kosten.

- Kostenpflichtige Sync-Modelle bieten beide.

- Joplin lässt sich mit einer eigenen Lösung verbinden.

- Das Sync-Backend bei Notesnook ist fremd gehostet.